JavaScript –Є SEO: –њ—А–Њ–≤–µ—А–Ї–∞ –і–Њ—Б—В—Г–њ–љ–Њ—Б—В–Є —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–≥–Њ —Б—В—А–∞–љ–Є—Ж

–і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е –±–Њ—В–Њ–≤

–Ы—О–±–Њ–є –≥—А–∞–Љ–Њ—В–љ—Л–є —Б–µ–Њ-–Њ–њ—В–Є–Љ–Є–Ј–∞—В–Њ—А –і–Њ–ї–ґ–µ–љ –Ј–љ–∞—В—М, –Ї–∞–Ї –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ JavaScript –Љ–Њ–ґ–µ—В –њ–Њ–≤–ї–Є—П—В—М –љ–∞ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–µ –њ—А–Њ–і–≤–Є–ґ–µ–љ–Є–µ. –≠—В–Њ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –≤–∞–ґ–љ–Њ, –≤–µ–і—М –µ—Б–ї–Є –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ –±–Њ—В—Л –љ–µ —Б–Љ–Њ–≥—Г—В —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞—В—М –Ї–Њ–љ—В–µ–љ—В, –љ–µ —Б–Љ–Њ–≥—Г—В –њ—А–Њ–≤–µ—Б—В–Є –µ–≥–Њ –∞–љ–∞–ї–Є–Ј, —В–Њ —Б—В—А–∞–љ–Є—Ж—Л, –≥–і–µ –Њ–љ —Б–Њ–і–µ—А–ґ–Є—В—Б—П, –љ–µ –њ—А–Њ–Є–љ–і–µ–Ї—Б–Є—А—Г—О—В—Б—П, –Њ–љ–Є –љ–µ –њ–Њ—П–≤–Є—В—Б—П –≤ —Б–њ–Є—Б–Ї–µ —А–µ–Ј—Г–ї—М—В–∞—В–Њ–≤, –Њ—В–≤–µ—З–∞—О—Й–Є—Е –љ–∞ –Ј–∞–њ—А–Њ—Б—Л –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–µ–є.

–Ю–і–љ–Є–Љ–Є –Є–Ј –Њ—Б–љ–Њ–≤–љ—Л—Е –≤–Њ–њ—А–Њ—Б–Њ–≤, –Ї–Њ—В–Њ—А—Л–µ —З–∞—Б—В–Њ –Ј–∞–і–∞—О—В—Б—П –њ—А–Є –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є, —П–≤–ї—П—О—В—Б—П:¬†«–Т–Є–і–µ–љ –ї–Є –Ї–Њ–љ—В–µ–љ—В –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —А–Њ–±–Њ—В–Њ–≤?» –Є–ї–Є «–Ъ–∞–Ї –Є—Б–њ—А–∞–≤–Є—В—М –њ—А–Њ–±–ї–µ–Љ—Л, —Б–≤—П–Ј–∞–љ–љ—Л–µ —Б –љ–µ–і–Њ—Б—В—Г–њ–љ–Њ—Б—В—М—О –Ї–Њ–љ—В–µ–љ—В–∞ –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Њ–≤?».

–С–∞–Ј–Њ–≤–∞—П –Є–љ—Д–Њ—А–Љ–∞—Ж–Є—П

–І—В–Њ –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є JavaScript?

–Ф–ї—П —Б–Њ–Ј–і–∞–љ–Є—П —Б—В—А–∞–љ–Є—Ж—Л —Б–∞–є—В–∞ –Љ–Њ–≥—Г—В –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М—Б—П —В–∞–Ї–Є–µ —Н–ї–µ–Љ–µ–љ—В—Л:

1) HTML. –≠—В–Њ—В —П–Ј—Л–Ї –њ—А–Њ–≥—А–∞–Љ–Љ–Є—А–Њ–≤–∞–љ–Є—П —Б—В–∞–ї –Њ—Б–љ–Њ–≤–љ—Л–Љ, –±–Њ–ї—М—И–∞—П —З–∞—Б—В—М —Б—В—А–∞–љ–Є—Ж—Л (—Б—В—А—Г–Ї—В—Г—А–∞, —Б—В–∞—В–Є—Б—В–Є—З–µ—Б–Ї–Є–є –Ї–Њ–љ—В–µ–љ—В –Є –Љ–љ–Њ–≥–Њ–µ –і—А—Г–≥–Њ–µ) –љ–∞–њ–Є—Б–∞–љ–∞ –љ–∞ –љ–µ–Љ;

2) CSS. –≠—В–Њ—В —П–Ј—Л–Ї –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П –і–ї—П —Б–Њ–Ј–і–∞–љ–Є—П —Б—В–Є–ї—П –≤–µ–±—Б—В—А–∞–љ–Є—Ж—Л, –µ–≥–Њ –Љ–Њ–ґ–љ–Њ —Б—З–Є—В–∞—В—М «–њ—А–µ–Ј–µ–љ—В–∞—Ж–Є–Њ–љ–љ–Њ–є —З–∞—Б—В—М—О» —Б–∞–є—В–∞;

3) JavaScript. –Ф–∞–љ–љ—Л–є —П–Ј—Л–Ї —Б–ї—Г–ґ–Є—В –і–ї—П –Є–љ—В–µ—А–∞–Ї—В–Є–≤–љ–Њ—Б—В–Є —А–µ—Б—Г—А—Б–∞ –Є —Б–Њ–Ј–і–∞–љ–Є—П –і–Є–љ–∞–Љ–Є—З–µ—Б–Ї–Є—Е —Н–ї–µ–Љ–µ–љ—В–Њ–≤ –≤–µ–±—Б—В—А–∞–љ–Є—Ж—Л.

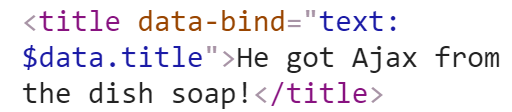

JavaScript –њ—А–Њ–њ–Є—Б—Л–≤–∞–µ—В—Б—П –≤ –Њ—Б–љ–Њ–≤–љ–Њ–є –Ї–Њ–і, –љ–∞–њ–Є—Б–∞–љ–љ—Л–є –љ–∞ HTML, –њ—А–Є –њ–Њ–Љ–Њ—Й–Є —Б–њ–µ—Ж–Є–∞–ї—М–љ—Л—Е —В–µ–≥–Њ–≤. –Э–∞ —Б–µ–≥–Њ–і–љ—П—И–љ–Є–є –і–µ–љ—М —А–∞–Ј—А–∞–±–Њ—В–∞–љ–Њ –Љ–љ–Њ–ґ–µ—Б—В–≤–Њ –±–Є–±–ї–Є–Њ—В–µ–Ї –Є —Д—А–µ–є–Љ–≤–Њ—А–Ї–Њ–≤ —Б JavaScript, —Н—В–Њ jQuery, AngularJS, ReactJS, EmberJS –Є –Љ–љ–Њ–≥–Є–µ –і—А—Г–≥–Є–µ.

–С–Є–±–ї–Є–Њ—В–µ–Ї–Є –Є —Д—А–µ–є–Љ–≤–Њ—А–Ї–Є JavaScript

1) AJAX.

–Ь–љ–Њ–≥–Є–µ —Б–ї—Л—И–∞–ї–Є –њ—А–Њ AJAX, –љ–Њ –Љ–∞–ї–Њ –Ј–љ–∞—О—В –Њ –љ–µ–Љ. AJAX — —Н—В–Њ –љ–∞–±–Њ—А –Љ–µ—В–Њ–і–Њ–≤ –і–ї—П —Б–Њ–Ј–і–∞–љ–Є—П —Б—В—А–∞–љ–Є—Ж, –њ—А–µ–і—Б—В–∞–≤–ї—П—О—Й–Є—Е —Б–Њ–±–Њ–є –Њ–±—К–µ–і–Є–љ–µ–љ–Є–µ –∞—Б–Є–љ—Е—А–Њ–љ–љ–Њ–≥–Њ JavaScript –Є XML. –Я—А–Є —Н—В–Њ–Љ —Б–Њ–Ј–і–∞–љ–љ—Л–µ –≤–µ–±–њ—А–Є–ї–Њ–ґ–µ–љ–Є—П —А–∞–±–Њ—В–∞—О—В —Б —Б–µ—А–≤–µ—А–Њ–Љ –≤ —Д–Њ–љ–Њ–≤–Њ–Љ —А–µ–ґ–Є–Љ–µ, –љ–µ –љ–∞–≥—А—Г–ґ–∞—П –Ј–∞–≥—А—Г–ґ–∞–µ–Љ—Г—О —Б—В—А–∞–љ–Є—Ж—Г. –Ф—А—Г–≥–Є–Љ–Є —Б–ї–Њ–≤–∞–Љ–Є, –Ј–∞–њ—Г—Б–Ї —Б—Ж–µ–љ–∞—А–Є—П async –њ–Њ–Ј–≤–Њ–ї—П–µ—В –і—А—Г–≥–Є–Љ —Д—Г–љ–Ї—Ж–Є—П–Љ –Є —Б—В—А–Њ–Ї–∞–Љ –Ї–Њ–і–∞ —А–∞–±–Њ—В–∞—В—М –±–µ–Ј –њ—А–µ—А—Л–≤–∞–љ–Є—П.

AJAX –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П –і–ї—П –љ–µ–њ–Њ–ї–љ–Њ–≥–Њ –Њ–±–љ–Њ–≤–ї–µ–љ–Є—П –Ї–Њ–љ—В–µ–љ—В–∞ –Є–ї–Є –Њ–±—Й–µ–≥–Њ –Љ–∞–Ї–µ—В–∞ –≤–µ–±—Б—В—А–∞–љ–Є—Ж—Л. –Ф–µ–ї–Њ –≤ —В–Њ–Љ, —З—В–Њ –њ—А–Є –Ј–∞–≥—А—Г–Ј–Ї–µ —Б—В—А–∞–љ–Є—Ж—Л —Б–µ—А–≤–µ—А –њ–Њ–ї—Г—З–∞–µ—В –Ј–∞–њ—А–Њ—Б –љ–∞ –Є–Ј–≤–ї–µ—З–µ–љ–Є–µ —Б –њ–Њ—Б–ї–µ–і—Г—О—Й–Є–Љ –Њ—В–Њ–±—А–∞–ґ–µ–љ–Є–µ–Љ. –Х—Б–ї–Є –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М AJAX, —В–Њ –љ–µ –љ—Г–ґ–љ–Њ –Ї–∞–ґ–і—Л–є —А–∞–Ј –Ј–∞–≥—А—Г–ґ–∞—В—М –≤—Б–µ –∞–Ї—В–Є–≤—Л, –њ–Њ–і–≥—А—Г–ґ–∞—О—В—Б—П —В–Њ–ї—М–Ї–Њ —В–µ, —З—В–Њ –Є–Ј–Љ–µ–љ–Є–ї–Є—Б—М –Є–ї–Є –і–Њ–±–∞–≤–Є–ї–Є—Б—М.

AJAX –Љ–Њ–ґ–љ–Њ –њ—А–µ–і—Б—В–∞–≤–Є—В—М –≤ –≤–Є–і–µ –љ–µ–±–Њ–ї—М—И–Њ–≥–Њ —Б–µ—А–≤–µ—А–∞. –Ю–і–љ–Є–Љ –Є–Ј —П—А–Ї–Є—Е –њ—А–Є–Љ–µ—А–Њ–≤ —П–≤–ї—П–µ—В—Б—П Google Maps, –≥–і–µ –њ—А–Њ–Є—Б—Е–Њ–і–Є—В –Њ–±–љ–Њ–≤–ї–µ–љ–Є–µ –≤–µ–±—Б—В—А–∞–љ–Є—Ж –±–µ–Ј –њ–Њ–ї–љ–Њ–є –њ–µ—А–µ–Ј–∞–≥—А—Г–Ј–Ї–Є.

2) –Ю–±—К–µ–Ї—В–љ—Л–є –Љ–∞–Ї–µ—В –і–Њ–Ї—Г–Љ–µ–љ—В (DOM).

–Ф–ї—П —В–Њ–≥–Њ, —З—В–Њ –Ј–∞–љ–Є–Љ–∞—В—М—Б—П —Б–µ–Њ-–Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–µ–є, –љ—Г–ґ–љ–Њ –Њ–±—П–Ј–∞—В–µ–ї—М–љ–Њ –Є–Љ–µ—В—М –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–Є–µ –Њ DOM, –≤–µ–і—М –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л –Є—Б–њ–Њ–ї—М–Ј—Г—О—В —Н—В–Њ –і–ї—П –∞–љ–∞–ї–Є–Ј–∞ –Є —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є—П –Ї–Њ–љ—В–µ–љ—В–∞.

–≠—В–Њ —В–Њ, —З—В–Њ –≤—Л –≤–Є–і–Є—В–µ –њ–Њ—Б–ї–µ –љ–∞–ґ–∞—В–Є—П –љ–∞ «–Я—А–Њ–≤–µ—А–Ї–∞ —Н–ї–µ–Љ–µ–љ—В–∞», –і—А—Г–≥–Є–Љ–Є —Б–ї–Њ–≤–∞–Љ–Є —Н—В–Њ –∞–ї–≥–Њ—А–Є—В–Љ –њ–Њ–ї—Г—З–µ–љ–Є—П –Є –њ—А–µ–Њ–±—А–∞–Ј–Њ–≤–∞–љ–Є–µ HTML –Ї–Њ–і–∞ –±—А–∞—Г–Ј–µ—А–Њ–Љ –≤ –Њ—В–Њ–±—А–∞–ґ–∞–µ–Љ—Г—О —Б—В—А–∞–љ–Є—Ж—Г, –Ї–Њ—В–Њ—А—Г—О –Љ—Л –≤–Є–і–Є–Љ –њ–Њ—Б–ї–µ –Ј–∞–≥—А—Г–Ј–Ї–Є.

–Р–ї–≥–Њ—А–Є—В–Љ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –њ—А–Њ—Б—В:

2.1) –С—А–∞—Г–Ј–µ—А –њ–Њ–ї—Г—З–∞–µ—В –Ї–Њ–љ—В–µ–љ—В –≤ HTML-–Ї–Њ–і–µ;

2.2) –Я—А–Њ–≤–Њ–і–Є—В—Б—П —Б–Ї–∞–љ–Є—А–Њ–≤–∞–љ–Є–µ –Є –∞–љ–∞–ї–Є–Ј —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–≥–Њ;

2.3) –Ш–Ј–≤–ї–µ—З–µ–љ–Є–µ —Н–ї–µ–Љ–µ–љ—В–Њ–≤ CSS, JavaScript, –Є–Ј–Њ–±—А–∞–ґ–µ–љ–Є–є.

DOM –њ—А–µ–і—Б—В–∞–≤–ї—П–µ—В —Б–Њ–±–Њ–є —А–µ–Ј—Г–ї—М—В–∞—В –∞–љ–∞–ї–Є–Ј–∞, –Є–Љ–µ—О—Й–Є–є –≤–Є–і —Б—В—А—Г–Ї—В—Г—А–Є—А–Њ–≤–∞–љ–љ–Њ–є, –Њ—А–≥–∞–љ–Є–Ј–Њ–≤–∞–љ–љ–Њ–є –≤–µ—А—Б–Є–µ–є –Ї–Њ–і–∞ —Б—В—А–∞–љ–Є—Ж—Л —А–µ—Б—Г—А—Б–∞.

–У–ї–∞–≤–љ—Л–Љ –Њ—В–ї–Є—З–Є–µ–Љ DOM –Њ—В –Є—Б—Е–Њ–і–љ–Њ–≥–Њ HTML –Ї–Њ–і–∞ —П–≤–ї—П–µ—В—Б—П —Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В—М –Є–Ј–Љ–µ–љ—П—В—М —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–µ —Б—В—А–∞–љ–Є—Ж—Л, –Њ–њ–Є—А–∞—П—Б—М –љ–∞ –≤–≤–µ–і–µ–љ–љ—Л–µ –Ј–∞–њ—А–Њ—Б—Л –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—П, –≤—А–µ–Љ—П —Б—Г—В–Њ–Ї –Є –і—А—Г–≥–Є—Е –њ–∞—А–∞–Љ–µ—В—А–Њ–≤ –±–ї–∞–≥–Њ–і–∞—А—П –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—О HTML, CSS –Є JavaScript. –Х–≥–Њ –µ—Й–µ —З–∞—Б—В–Њ –љ–∞–Ј—Л–≤–∞—О—В –і–Є–љ–∞–Љ–Є—З–µ—Б–Ї–Є–Љ HTML.

| –Ш—Б—В–Њ—З–љ–Є–Ї HTML | DOM |

|

|

3) –С–µ–Ј–≥–ї–∞—Б–љ—Л–є –њ—А–Њ—Б–Љ–Њ—В—А.

–Я–Њ–і –±–µ–Ј–≥–ї–∞—Б–љ—Л–Љ –њ—А–Њ—Б–Љ–Њ—В—А–Њ–Љ –њ–Њ–љ–Є–Љ–∞–µ—В—Б—П –њ—А–Њ—Б–Љ–Њ—В—А —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–≥–Њ –±–µ–Ј –Ј–∞–≥—А—Г–Ј–Ї–Є –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М—Б–Ї–Њ–≥–Њ –Є–љ—В–µ—А—Д–µ–є—Б–∞. –Я–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л, —В–∞–Ї–Є–µ –Ї–∞–Ї Google, –њ–Њ–ї—М–Ј—Г—О—В—Б—П —Н—В–Њ–є —Д—Г–љ–Ї—Ж–Є–µ–є –і–ї—П –Њ—Ж–µ–љ–Ї–Є –њ–Њ–ї–µ–Ј–љ–Њ—Б—В–Є –Є –Ї–∞—З–µ—Б—В–≤–∞ –Ї–Њ–љ—В–µ–љ—В–∞ —Б—В—А–∞–љ–Є—Ж—Л.

–Э–∞ —Б–µ–≥–Њ–і–љ—П—И–љ–Є–є –і–µ–љ—М –µ—Б—В—М —Б–њ–µ—Ж–Є–∞–ї—М–љ—Л–µ –Є–љ—Б—В—А—Г–Љ–µ–љ—В—Л, –љ–∞–њ—А–Є–Љ–µ—А, PhantomJS –Є Zombie.js, –њ–Њ–Ј–≤–Њ–ї—П—О—Й–Є–µ –і–µ–ї–∞—В—М –±–µ–Ј–≥–ї–∞—Б–љ—Л–є –њ—А–µ–і–њ—А–Њ—Б–Љ–Њ—В—А –і–ї—П —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П —А–µ–Ј—Г–ї—М—В–∞—В–∞ –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є–Є, —Б–Њ–≤–µ—А—И–µ–љ–Є—П –њ—А–µ–і–≤–∞—А–Є—В–µ–ї—М–љ–Њ–≥–Њ —А–µ–љ–і–µ—А–Є–љ–≥–∞.

–Я–Њ—З–µ–Љ—Г –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ JavaScript –Љ–Њ–ґ–µ—В –Ј–∞—В—А—Г–і–љ–Є—В—М –њ—А–Њ–і–≤–Є–ґ–µ–љ–Є–µ –≤ –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–∞—Е, –Ї–∞–Ї –Є—Б–њ—А–∞–≤–Є—В—М —Н—В–Њ?

–°—Г—Й–µ—Б—В–≤—Г–µ—В —В—А–Є –Њ—Б–љ–Њ–≤–љ—Л—Е —Д–∞–Ї—В–Њ—А–∞,¬†–њ—А–Є –Ї–Њ—В–Њ—А—Л—Е –і–Њ–ї–ґ–љ—Л –±—Л—В—М –≤—Л–њ–Њ–ї–љ–µ–љ—Л¬†–њ—А–Є¬†–Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ JavaScript:

1) –Т–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –њ—А–Њ–≤–µ–і–µ–љ–Є–µ —Б–Ї–∞–љ–∞ — –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —А–Њ–±–Њ—В—Л –Љ–Њ–≥—Г—В —Б–Ї–∞–љ–Є—А–Њ–≤–∞—В—М –Є —А–∞—Б–њ–Њ–Ј–љ–∞—В—М —Б—В—А–∞–љ–Є—Ж—Л —А–µ—Б—Г—А—Б–∞;

2) –Ф–Њ—Б—В—Г–њ–љ–Њ—Б—В—М –Ї–Њ–љ—В–µ–љ—В–∞ — –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —А–Њ–±–Њ—В–Њ–≤ –Њ—В–Ї—А—Л—В –і–Њ—Б—В—Г–њ –Ї –Ї–Њ–љ—В–µ–љ—В—Г, –Њ–љ–Є —Б–њ–Њ—Б–Њ–±–љ—Л –µ–≥–Њ –њ—А–Њ–∞–љ–∞–ї–Є–Ј–Є—А–Њ–≤–∞—В—М;

3) –Т–Њ—Б–њ—А–Є–љ–Є–Љ–∞–µ–Љ–Њ—Б—В—М —А–µ—Б—Г—А—Б–∞ — –Њ—Ж–µ–љ–Ї–∞ –≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є–Є (–ї–∞—В–µ–љ—В–љ–Њ—Б—В—М)

–°–Ї–∞–љ–Є—А–Њ–≤–∞–љ–Є–µ –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ–Є —А–Њ–±–Њ—В–∞–Љ–Є.

–Я—А–Є —Н—В–Њ–Љ –њ–Њ–і–љ–Є–Љ–∞–µ—В—Б—П –≤–∞–ґ–љ—Л–є –≤–Њ–њ—А–Њ—Б, —Б–њ–Њ—Б–Њ–±–љ—Л –ї–Є –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —А–Њ–±–Њ—В—Л –Њ—В—Л—Б–Ї–∞—В—М URL-–∞–і—А–µ—Б–∞ —Б—В—А–∞–љ–Є—Ж, —А–∞—Б–њ–Њ–Ј–љ–∞—В—М —Б—В—А—Г–Ї—В—Г—А—Г –њ—А–Њ–µ–Ї—В–∞? –Ч–і–µ—Б—М –Љ–Њ–≥—Г—В –њ–Њ—П–≤–Є—В—М—Б—П –і–≤–µ –њ—А–Њ–±–ї–µ–Љ—Л:

1) –Э–µ–Ї–Њ—В–Њ—А—Л–µ —Н–ї–µ–Љ–µ–љ—В—Л —Б—В—А–∞–љ–Є—Ж—Л –Њ–Ї–∞–Ј–∞–ї–Є—Б—М –Ј–∞–±–ї–Њ–Ї–Є—А–Њ–≤–∞–љ–љ—Л–Љ–Є (—Б–ї—Г—З–∞–є–љ–Њ –Є–ї–Є –љ–µ—Б–ї—Г—З–∞–є–љ–Њ) –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —А–Њ–±–Њ—В–Њ–≤ –Є–Ј-–Ј–∞ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П JavaScript;

2) –Э–∞—А—Г—И–µ–љ–Є–µ —Б—В—А—Г–Ї—В—Г—А–љ—Л—Е —Б–≤—П–Ј–µ–є –Є–Ј-–Ј–∞ –Ј–∞–Љ–µ–љ—Л —В–µ–≥–Њ–≤ HTML –љ–∞ —Б–Њ–±—Л—В–Є—П JavaScript.

–Я–Њ—З–µ–Љ—Г –±–ї–Њ–Ї–Є—А–Њ–≤–Ї–∞ —Б–Ї–∞–љ–Є—А–Њ–≤–∞–љ–Є—П –Є–Ј-–Ј–∞ JavaScript –Њ–Ї–∞–Ј—Л–≤–∞–µ—В –љ–µ–≥–∞—В–Є–≤–љ–Њ–µ –≤–ї–Є—П–љ–Є–µ –љ–∞ –њ—А–Њ–і–≤–Є–ґ–µ–љ–Є–µ?

–Х—Б–ї–Є –Њ–њ—А–µ–і–µ–ї–µ–љ–љ—Л–µ —Н–ї–µ–Љ–µ–љ—В—Л —Б—В—А–∞–љ–Є—Ж—Л –љ–µ–і–Њ—Б—В—Г–њ–љ—Л –і–ї—П —Б–Ї–∞–љ–∞ –Є–Ј-–Ј–∞ JavaScript, –Ј–љ–∞—З–Є—В –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї –љ–µ —Б–Љ–Њ–ґ–µ—В –њ–Њ–ї–љ–Њ—Б—В—М—О –њ—А–Њ–≤–µ—А–Є—В—М –Є –Њ—Ж–µ–љ–Є—В—М –≤—Б–µ —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–µ, –∞ –њ–Њ—Б–µ—В–Є—В–µ–ї—М —Н—В–Њ–є —Б—В—А–∞–љ–Є—Ж—Л –љ–µ —Б–Љ–Њ–ґ–µ—В —Г–≤–Є–і–µ—В—М –Ј–∞–±–ї–Њ–Ї–Є—А–Њ–≤–∞–љ–љ—Л–µ —Н–ї–µ–Љ–µ–љ—В—Л. –Я–Њ–Є—Б–Ї–Њ–≤–∞—П —Б–Є—Б—В–µ–Љ–∞ —Б—В–∞—А–∞–µ—В—Б—П –њ—А–µ–і–Њ—Б—В–∞–≤–Є—В—М –љ–∞–Є–±–Њ–ї–µ–µ –њ–Њ–ї–µ–Ј–љ—Л–є –Є –Ї–∞—З–µ—Б—В–≤–µ–љ–љ—Л–є —А–µ–Ј—Г–ї—М—В–∞—В –њ–Њ –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ –Ј–∞–њ—А–Њ—Б–∞–Љ, –Њ–љ–Є –њ–Њ —Г–Љ–Њ–ї—З–∞–љ–Є—О —Б—З–Є—В–∞—О—В —Б—В—А–∞–љ–Є—Ж—Л —Б –Ј–∞–±–ї–Њ–Ї–Є—А–Њ–≤–∞–љ–љ—Л–Љ–Є —Н–ї–µ–Љ–µ–љ—В–∞–Љ–Є –Љ–µ–љ–µ–µ –њ—А–Є–≤–ї–µ–Ї–∞—В–µ–ї—М–љ—Л–Љ–Є –і–ї—П –њ–Њ—Б–µ—В–Є—В–µ–ї–µ–є. –Ґ–∞–Ї–ґ–µ –љ–∞–ї–Є—З–Є–µ –Ј–∞–±–ї–Њ–Ї–Є—А–Њ–≤–∞–љ–љ—Л—Е —Н–ї–µ–Љ–µ–љ—В–Њ–≤ –Љ–Њ–ґ–µ—В –±—Л—В—М —А–∞—Б—Ж–µ–љ–µ–љ–Њ –Ї–∞–Ї —Г–Љ—Л—И–ї–µ–љ–љ–Њ-–≤—А–µ–і–Њ–љ–Њ—Б–љ–Њ–µ, —В–∞–Ї–∞—П —Б—В—А–∞–љ–Є—Ж–∞ –Љ–Њ–ґ–µ—В –љ–µ –њ—А–Њ–є—В–Є –Є–љ–і–µ–Ї—Б–∞—Ж–Є—О.

–Х—Б—В—М –Љ–љ–Њ–ґ–µ—Б—В–≤–Њ –њ—А–Њ–≥—А–∞–Љ–Љ-–Є–љ—Б—В—А—Г–Љ–µ–љ—В–Њ–≤, –њ–Њ–Ј–≤–Њ–ї—П—О—Й–Є—Е –њ—А–Њ–≤–µ—А–Є—В—М –љ–∞ –і–Њ—Б—В—Г–њ–љ–Њ—Б—В—М —Б–Ї–∞–љ–Є—А–Њ–≤–∞–љ–Є—П —Б—В—А–∞–љ–Є—Ж –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–∞–Љ–Є, –љ–∞–њ—А–Є–Љ–µ—А, —Н—В–Њ –Љ–Њ–≥—Г—В –±—Л—В—М Fetch –Є Render, –Є–ї–Є –Є–љ—Б—В—А—Г–Љ–µ–љ—В—Л —Б Google, robots.txt , –Ї–Њ—В–Њ—А—Л–µ –њ–Њ–Ї–∞–ґ—Г—В —Н–ї–µ–Љ–µ–љ—В—Л, –Ј–∞–±–ї–Њ–Ї–Є—А–Њ–≤–∞–љ–љ—Л–µ –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ—Л.

–Ґ—А—Г–і–љ–Њ—Б—В—М —Б –±–ї–Њ–Ї–Є—А–Њ–≤–Ї–Њ–є —Н–ї–µ–Љ–µ–љ—В–Њ–≤ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ –ї–µ–≥–Ї–Њ —А–µ—И–Є—В—М,¬†–і–Њ—Б—В–∞—В–Њ—З–љ–Њ –Њ—В–Ї—А—Л—В—М –і–Њ—Б—В—Г–њ –Ї–Њ –≤—Б–µ–Љ –љ—Г–ґ–љ—Л–Љ —Н–ї–µ–Љ–µ–љ—В–∞–Љ —Б—В—А–∞–љ–Є—Ж—Л.

–Ю–±—А–∞—В–Є—В–µ –≤–љ–Є–Љ–∞–љ–Є–µ –љ–∞ –≤–∞–ґ–љ—Л–є –Љ–Њ–Љ–µ–љ—В, –љ–∞–і–Њ –і–µ–є—Б—В–≤–Є—В–µ–ї—М–љ–Њ —А–∞–Ј–±–Є—А–∞—В—М—Б—П –≤ —Н—В–Њ–є –Њ–±–ї–∞—Б—В–Є. –Я—А–Є–љ–Є–Љ–∞—В—М —А–µ—И–µ–љ–Є–µ –њ—А–Њ –Њ—В–Ї—А—Л—В–Є–µ/–±–ї–Њ–Ї–Є—А–Њ–≤–Ї—Г –і–Њ—Б—В—Г–њ–∞ –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Њ–≤ –Ї –Њ–њ—А–µ–і–µ–ї–µ–љ–љ—Л–Љ —Н–ї–µ–Љ–µ–љ—В–∞–Љ —Б—В—А–∞–љ–Є—Ж —Б–ї–µ–і—Г–µ—В –≤–Љ–µ—Б—В–µ —Б –Њ–њ—Л—В–љ—Л–Љ–Є —Б–њ–µ—Ж–Є–∞–ї–Є—Б—В–∞–Љ–Є-—А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–∞–Љ–Є.

–°—В—А—Г–Ї—В—Г—А–Є—А–Њ–≤–∞–љ–Є–µ —Б—Б–∞–є—В–Њ–≤ (–≤–љ—Г—В—А–µ–љ–љ–Є–µ —Б–≤—П–Ј–Є).

–†–∞–Ј—А–∞–±–Њ—В–Ї–∞ –≤–љ—Г—В—А–µ–љ–љ–µ–є —Б–≤—П–Ј–Є —Б—В—А–∞–љ–Є—Ж — –≤–∞–ґ–љ—Л–є —Н—В–∞–њ —А–∞–±–Њ—В—Л. –Ф–ї—П —Н—В–Њ–≥–Њ —Б–ї–µ–і—Г–µ—В –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М –Њ–±—Л—З–љ—Л–µ —В–µ–≥–Є-–Ї–Њ–Љ–∞–љ–і—Л HTML –Є–ї–Є DOM (–њ—А–Є —Н—В–Њ–Љ –≤—Б–µ —А–∞–≤–љ–Њ –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В—Б—П —В–µ–≥ –≤–Є–і–∞ hrefs = «www.example.com») —Б –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ–Љ JavaScript-—Д—Г–љ–Ї—Ж–Є–є –і–ї—П –њ–µ—А–µ–Љ–µ—Й–µ–љ–Є—П –њ–Њ—Б–µ—В–Є—В–µ–ї—П –њ–Њ –≤—Б–µ–Љ —Б—В—А–∞–љ–Є—Ж–∞–Љ —А–µ—Б—Г—А—Б–∞.

–Э–µ —Б—В–Њ–Є—В –њ—А–Є–Љ–µ–љ—П—В—М JavaScript onclick events –і–ї—П –≤–љ—Г—В—А–µ–љ–љ–µ–є —Б–≤—П–Ј–Є, —Е–Њ—В—М –≤–њ–Њ–ї–љ–µ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ, —З—В–Њ –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Є —Б–Љ–Њ–≥—Г—В –Њ—В—Л—Б–Ї–∞—В—М —Б—В—А–∞–љ–Є—Ж—Л –Є –њ—А–Њ–∞–љ–∞–ї–Є–Ј–Є—А–Њ–≤–∞—В—М –Є—Е (–≤ —Н–ї–µ–Љ–µ–љ—В–∞—Е –Ї–Њ–і–∞ JavaScript –Є–ї–Є XML-—Д–∞–є–ї–∞—Е Sitemap). –Я—А–Њ–±–ї–µ–Љ–∞ –≤ —В–Њ–Љ, —А–Њ–±–Њ—В –љ–µ —Б–≤—П–ґ–µ—В —В–µ —Б—В—А–∞–љ–Є—Ж—Л —Б –Њ–±—Й–µ–є —Б—В—А—Г–Ї—В—Г—А–Њ–є —А–µ—Б—Г—А—Б–∞.

–Т–љ—Г—В—А–µ–љ–љ—П—П —Б–≤—П–Ј—М —Б–ї—Г–ґ–Є—В –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —А–Њ–±–Њ—В–Њ–≤ –і–ї—П –Њ—Ж–µ–љ–Ї–Є –≤–∞–ґ–љ–Њ—Б—В–Є –Є –њ–Њ–ї–µ–Ј–љ–Њ—Б—В–Є –≤–µ–±—Б—В—А–∞–љ–Є—Ж, –≤ –љ–µ–Ї–Њ—В–Њ—А—Л—Е —Б–ї—Г—З–∞—Е –Њ–љ–Є –Љ–Њ–≥—Г—В¬†–Њ–Ї–∞–Ј—Л–≤–∞—В—М –Њ—З–µ–љ—М —Б–Є–ї—М–љ–Њ–µ –≤–ї–Є—П–љ–Є–µ –Є –њ–µ—А–µ–Њ–њ—А–µ–і–µ–ї—П—В—М ¬Ђ–њ–Њ–і—Б–Ї–∞–Ј–Ї–Є SEO¬ї, —В–∞–Ї–Є–µ –Ї–∞–Ї –Ї–∞–љ–Њ–љ–Є—З–µ—Б–Ї–Є–µ —В–µ–≥–Є.

–°—В—А—Г–Ї—В—Г—А–∞ URL.

–Ш—Б—В–Њ—А–Є—З–µ—Б–Ї–Є –≤–µ–±-—Б–∞–є—В—Л –љ–∞ –Њ—Б–љ–Њ–≤–µ JavaScript (–љ–∞–њ—А–Є–Љ–µ—А, ¬Ђ—Б–∞–є—В—Л AJAX¬ї) –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–ї–Є –Є–і–µ–љ—В–Є—Д–Є–Ї–∞—В–Њ—А—Л —Д—А–∞–≥–Љ–µ–љ—В–Њ–≤ (#) –≤ URL-–∞–і—А–µ—Б–∞—Е.

–Х—Б—В—М –љ–µ—Б–Ї–Њ–ї—М–Ї–Њ —Б–Њ–≤–µ—В–Њ–≤, –Ї–Њ—В–Њ—А—Л—Е —Б–ї–µ–і—Г–µ—В –њ—А–Є–і–µ—А–ґ–Є–≤–∞—В—М—Б—П:

1) –°—В–∞—А–∞–є—В–µ—Б—М –Є–Ј–±–µ–≥–∞—В—М –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М –Њ–і–Є–љ–Њ—З–љ—Л–є —Е—Н—И #, –њ–Њ—В–Њ–Љ—Г —З—В–Њ —Н—В–Њ—В –Ј–љ–∞–Ї –љ–µ —Б–Ї–∞–љ–Є—А—Г–µ—В—Б—П –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ–Є —А–Њ–±–Њ—В–∞–Љ–Є. –Ю–љ –љ—Г–ґ–µ–љ –і–ї—П —Б–Њ–Ј–і–∞–љ–Є–є —Б—Б—Л–ї–Ї–Є –њ–µ—А–µ—Е–Њ–і–∞, —В–Њ –µ—Б—В—М —В–∞–Ї–Є—Е —Б—Б—Л–ї–Њ–Ї, –Ї–Њ—В–Њ—А—Л–µ –њ–µ—А–µ–љ–∞–њ—А–∞–≤–ї—П—О—В –Ї –Њ–њ—А–µ–і–µ–ї–µ–љ–љ–Њ–є —З–∞—Б—В–Є —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–≥–Њ –љ–∞ —Б—В—А–∞–љ–Є—Ж–µ. –Т—Б–µ, —З—В–Њ –љ–∞—Е–Њ–і–Є—В—Б—П –њ–Њ—Б–ї–µ —Н—В–Њ–≥–Њ —Б–Є–Љ–≤–Њ–ї–∞ –≤ –∞–і—А–µ—Б–љ–Њ–є —Б—Б—Л–ї–Ї–Є –љ–µ –Њ—В–њ—А–∞–≤–ї—П–µ—В—Б—П –љ–∞ —Б–µ—А–≤–µ—А, –≤–µ–±—Б—В—А–∞–љ–Є—Ж–∞ –±—Г–і–µ—В –њ—А–Њ–Ї—А—Г—З–Є–≤–∞—В—М—Б—П –і–Њ –њ–µ—А–≤–Њ–≥–Њ —Н–ї–µ–Љ–µ–љ—В–∞, —Б–Њ–≤–њ–∞–і–∞—О—Й–µ–≥–Њ —Б —Г–Ї–∞–Ј–∞–љ–љ—Л–Љ –Є–і–µ–љ—В–Є—Д–Є–Ї–∞—В–Њ—А–Њ–Љ. –Я–Њ—Н—В–Њ–Љ—Г –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї –У—Г–≥–ї —Б–Њ–≤–µ—В—Г–µ—В –љ–µ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М –і–∞–љ–љ—Л–є —Б–Є–Љ–≤–Њ–ї –≤ URL-–∞–і—А–µ—Б–∞—Е.;

2) –Э–µ —Б—В–Њ–Є—В —В–∞–Ї–ґ–µ –њ—А–Њ–њ–Є—Б—Л–≤–∞—В—М URL-–∞–і—А–µ—Б–∞ Hashbang (#!), –Є—Е —А–∞—Б–њ–Њ–Ј–љ–∞–µ—В —В–Њ–ї—М–Ї–Њ –њ–Њ–Є—Б–Ї–Њ–≤–∞—П —Б–Є—Б—В–µ–Љ–∞ –С–Є–љ–≥, –У—Г–≥–ї –Њ—В–Ї–∞–Ј–∞–ї–Є—Б—М –Њ—В –њ–Њ–і–і–µ—А–ґ–Ї–Є –і–∞–љ–љ–Њ–≥–Њ —Д–Њ—А–Љ–∞—В–∞ –Є–Ј-–Ј–∞ –њ–Њ–њ—Л—В–Њ–Ї –Љ–∞–љ–Є–њ—Г–ї—П—Ж–Є–є —Б –њ–Њ—Е–Њ–ґ–Є–Љ escaped_fragment HTML. –†–∞—Б—Б–Љ–Њ—В—А–Є–Љ –љ–∞ –і–≤—Г—Е –њ—А–Є–Љ–µ—А–∞—Е:

2.1) –Т –Њ—А–Є–≥–Є–љ–∞–ї–µ –і–Њ–ї–ґ–љ–Њ —Б–Њ–і–µ—А–ґ–∞—В—Б—П #! (hashbang) –≤ URL-–∞–і—А–µ—Б–µ –Ї–∞–Ї —Б–≤–Є–і–µ—В–µ–ї—М—Б—В–≤–Њ —Б—Г—Й–µ—Б—В–≤–Њ–≤–∞–љ–Є—П –Њ–њ—А–µ–і–µ–ї–µ–љ–љ–Њ–≥–Њ —Д—А–∞–≥–Љ–µ–љ—В–∞ –Є–ї–Є –Љ–µ—В–∞–і–∞–љ–љ—Л—Е <meta name = «fragment» content = «!»>;

2.2) –Э–∞ –њ—А–∞–Ї—В–Є–Ї–µ —Б–Є–Љ–≤–Њ–ї #! (hashbang) –Ј–∞–Љ–µ–љ—П–µ—В—Б—П –љ–∞ ¬Ђ_escaped_fragment_¬ї, –і–µ–ї–∞—П –∞–і—А–µ—Б –і–ї–Є–љ–љ—Л–Љ, –њ–Њ—Е–Њ–ґ–Є–Љ –љ–∞ –≤–Ј–ї–Њ–Љ–∞–љ–љ—Л–є.

–У—Г–≥–ї —Б–Њ–≤–µ—В—Г–µ—В:

1) –Ш—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М API –Є—Б—В–Њ—А–Є–Є PushState, —З—В–Њ –±–∞–Ј–Є—А—Г–µ—В—Б—П –љ–∞ –Є—Б—В–Њ—А–Є–Є –њ—А–Њ—Б–Љ–Њ—В—А–∞ –≤–µ–±—Б—В—А–∞–љ–Є—Ж. –Ф—А—Г–≥–Є–Љ–Є —Б–ї–Њ–≤–∞–Љ–Є, –њ—А–Є –Ј–∞–≥—А—Г–Ј–Ї–µ —Б—В—А–∞–љ–Є—Ж—Л –њ–Њ–≤—В–Њ—А–љ–Њ –Њ–±–љ–Њ–≤–ї—П—О—В—Б—П –ї–Є—И—М —В–µ —Н–ї–µ–Љ–µ–љ—В—Л, —З—В–Њ –Є–Ј–Љ–µ–љ–Є–ї–Є—Б—М —Б –њ—А–Њ—И–ї–Њ–≥–Њ –њ–Њ—Б–µ—Й–µ–љ–Є—П. –У—Г–≥–ї –Њ–і–Њ–±—А—П–µ—В —Н—В–Њ, –њ–Њ–і–і–µ—А–ґ–Є–≤–∞—П –±—А–∞—Г–Ј–µ—А–љ—Г—О –љ–∞–≤–Є–≥–∞—Ж–Є—О –і–ї—П –≤–Є–Ј—Г–∞–ї–Є–Ј–∞—Ж–Є–Є. –Ю—Б–Њ–±–µ–љ–љ–Њ —Е–Њ—А–Њ—И–Њ –њ—А–Є–Љ–µ–љ—П—В—М —Н—В–Њ—В –Љ–µ—В–Њ–і –і–ї—П «–±–µ—Б–Ї–Њ–љ–µ—З–љ–Њ–є –њ—А–Њ–Ї—А—Г—В–Ї–Є», —В–Њ –µ—Б—В—М –і–ї—П —Б–Є—В—Г–∞—Ж–Є–є, –Ї–Њ–≥–і–∞ –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї—М —З–∞—Б—В–Њ –љ–∞–ґ–Є–Љ–∞–µ—В –љ–∞ —А–∞–Ј–љ—Л–µ —З–∞—Б—В–Є –≤–µ–±—Б—В—А–∞–љ–Є—Ж—Л, –њ—А–Є —Н—В–Њ–Љ –њ—А–Њ–Є—Б—Е–Њ–і–Є—В –Њ–±–љ–Њ–≤–ї–µ–љ–Є–µ URL-–∞–і—А–µ—Б—Б–∞. –°—З–Є—В–∞–µ—В—Б—П —Е–Њ—А–Њ—И–Є–Љ, –µ—Б–ї–Є –њ–Њ—Б–ї–µ –њ—А–Њ–Ї—А—Г—В–Ї–Є —Б—В—А–∞–љ–Є—Ж—Л –≤–љ–Є–Ј, –њ—А–Њ–Є—Б—Е–Њ–і–Є—В –Ј–∞–≥—А—Г–Ј–Ї–∞ –Ї–Њ–љ—В–µ–љ—В–∞ –±–µ–Ј –Њ–±–љ–Њ–≤–ї–µ–љ–Є—П –≤—Б–µ–є —Б—В—А–∞–љ–Є—Ж—Л.

2) –Ь–Њ–ґ–љ–Њ —Б–і–µ–ї–∞—В—М –±–µ—Б–Ї–Њ–љ–µ—З–љ—Г—О –њ—А–Њ–Ї—А—Г—В–Ї—Г –±–µ–Ј –њ–Њ—Б—В–Њ—П–љ–љ–Њ–є –њ–µ—А–µ–Ј–∞–≥—А—Г–Ј–Ї–Є –њ—А–Є –њ–Њ–Љ–Њ—Й–Є replaceState ().

–Т–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В—М –≤–Ј–∞–Є–Љ–Њ–і–µ–є—Б—В–≤–Є—П —А–µ—Б—Г—А—Б–∞ —Б –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ–Є —А–Њ–±–Њ—В–∞–Љ–Є.

–Т—Л—И–µ –Њ–±—Б—Г–ґ–і–∞–ї–Њ—Б—М, —З—В–Њ –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Є –њ—А–Є–Љ–µ–љ—П—О—В —А–µ–ґ–Є–Љ –±–µ–Ј–≥–ї–∞—Б–љ–Њ–≥–Њ –њ—А–Њ—Б–Љ–Њ—В—А–∞ –і–ї—П –Њ—Ж–µ–љ–Ї–Є —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–≥–Њ –Ї–Њ–љ—В–µ–љ—В–∞ –љ–∞ —Б–Њ–Њ—В–≤–µ—В—Б—В–≤–Є–µ –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ —Д—А–∞–Ј–∞–Љ. –Я—А–Є —Н—В–Њ–Љ –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї –Љ–Њ–ґ–µ—В —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞—В—М –љ–µ–Ї–Њ—В–Њ—А—Л–µ —Н–ї–µ–Љ–µ–љ—В—Л —Б–∞–є—В–∞, —Б–і–µ–ї–∞–љ–љ—Л–µ –њ—А–Є –њ–Њ–Љ–Њ—Й–Є JavaScript, –њ–Њ–ї—М–Ј—Г—П—Б—М –њ—А–Є —Н—В–Њ–Љ DOM.

–Э–Њ –і–Њ—Б—В–∞—В–Њ—З–љ–Њ —З–∞—Б—В–Њ –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —А–Њ–±–Њ—В—Л –љ–µ —Б–њ–Њ—Б–Њ–±–љ—Л —А–∞—Б–њ–Њ–Ј–љ–∞—В—М —Д—А–∞–≥–Љ–µ–љ—В—Л –Ї–Њ–і–∞ –љ–∞ JavaScript, —З—В–Њ –љ–µ–≥–∞—В–Є–≤–љ–Њ –≤–ї–Є—П–µ—В –љ–∞ –њ—А–Њ–і–≤–Є–ґ–µ–љ–Є–µ. –Я–Њ—Н—В–Њ–Љ—Г –љ—Г–ґ–љ–Њ –Ј–љ–∞—В—М, —Б–њ–Њ—Б–Њ–±–љ—Л –ї–Є –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —А–Њ–±–Њ—В—Л –∞–љ–∞–ї–Є–Ј–Є—А–Њ–≤–∞—В—М –Є —Б–Ї–∞–љ–Є—А–Њ–≤–∞—В—М –≤–µ—Б—М –Ї–Њ–љ—В–µ–љ—В. –Э–µ—В —Б–Љ—Л—Б–ї–∞ —Б—В—А–Њ–Є—В—М –і–Њ–≥–∞–і–Ї–Є, –љ—Г–ґ–љ–Њ –њ—А–Њ–≤–µ—А—П—В—М –і–Њ—Б—В—Г–њ–љ–Њ—Б—В—М —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–≥–Њ —А–µ—Б—Г—А—Б–∞.

–Я–Њ–≤–µ–і–µ–љ–Є–µ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–≥–Њ —А–Њ–±–Њ—В–∞, –Њ–±–љ–∞—А—Г–ґ–Є–≤—И–µ–≥–Њ JavaScript, –Є–Љ–µ–µ—В —А—П–і –Њ—Б–Њ–±–µ–љ–љ–Њ—Б—В–µ–є:

1) –Я–Њ–Є—Б–Ї–Њ–≤—Л–µ –±–Њ—В—Л –љ–µ –≤—Л–њ–Њ–ї–љ—П—О—В –Ї–∞–Ї–Є–µ-—В–Њ –і–µ–є—Б—В–≤–Є—П, –њ—А–µ–і—Г—Б–Љ–Њ—В—А–µ–љ–љ—Л–µ –љ–∞ –њ–Њ–ї—Г—З–µ–љ–Є–µ –і–Њ–њ–Њ–ї–љ–Є—В–µ–ї—М–љ–Њ–є –Є–љ—Д–Њ—А–Љ–∞—Ж–Є–Є. –Э–∞–њ—А–Є–Љ–µ—А, –µ—Б–ї–Є –≤—Л —А–∞–Ј–Љ–µ—Б—В–Є—В–µ —Б—В–∞—В—М–Є, –њ—А–Њ—З–Є—В–∞—В—М –Ї–Њ—В–Њ—А—Л–µ –Љ–Њ–ґ–љ–Њ —В–Њ–ї—М–Ї–Њ –њ–Њ—Б–ї–µ —А–µ–≥–Є—Б—В—А–∞—Ж–Є–Є, —В–Њ –Њ–љ–Є –љ–µ –њ—А–Њ–є–і—Г—В –Є–љ–і–µ–Ї—Б–∞—Ж–Є—О, —В–∞–Ї –Ї–∞–Ї –±–Њ—В—Л –љ–µ —Б–Љ–Њ–≥—Г—В –њ–Њ–ї—Г—З–Є—В—М –і–Њ—Б—В—Г–њ –Ї —Н—В–Њ–Љ—Г –Ї–Њ–љ—В–µ–љ—В—Г. –Я–Њ—Н—В–Њ–Љ—Г —Б—В–Њ–Є—В –њ–Њ–Ј–∞–±–Њ—В–Є—В—Б—П, —З—В–Њ–±—Л –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Є –Љ–Њ–≥–ї–Є –њ–Њ–ї—Г—З–Є—В—М –і–Њ—Б—В—Г–њ –Ї —Н—В–Њ–Љ—Г –Ї–Њ–љ—В–µ–љ—В—Г.

2) –Я–Њ–Є—Б–Ї–Њ–≤—Л–µ –±–Њ—В—Л –Љ–Њ–≥—Г—В –њ—А–Њ–њ—Г—Б—В–Є—В—М —Б—В—А–∞–љ–Є—Ж—Г, –µ—Б–ї–Є –њ—А–Њ–Є—Б—Е–Њ–і–Є—В –і–Њ–ї–≥–∞—П –Ј–∞–≥—А—Г–Ј–Ї–∞. –Т–∞–ґ–љ–Њ —Г–±–µ–і–Є—В—Б—П —З—В–Њ –њ–Њ—Б–ї–µ —Б—А–∞–±–∞—В—Л–≤–∞–љ–Є—П —Б–Њ–±—Л—В–Є–є –Ј–∞–≥—А—Г–Ј–Ї–Є JavaScript —Б—В—А–∞–љ–Є—Ж–∞ –Њ—В–Ї—А—Л–≤–∞–µ—В—Б—П –Љ–µ–љ–µ–µ, —З–µ–Љ –Ј–∞ 5 —Б–µ–Ї—Г–љ–і. –Х—Б–ї–Є –і–ї–Є—В–µ–ї—М–љ–Њ—Б—В—М –Ј–∞–≥—А—Г–Ј–Ї–Є –±—Г–і–µ—В –±–Њ–ї–µ–µ, –µ—Б—В—М –±–Њ–ї—М—И–∞—П –≤–µ—А–Њ—П—В–љ–Њ—Б—В—М, —З—В–Њ –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Є –љ–µ –≤–Є–і—П—В –Ј–∞–≥—А—Г–ґ–∞–µ–Љ—Л–є –Ї–Њ–љ—В–µ–љ—В.

–Э–µ—В –Ї–Њ–љ–Ї—А–µ—В–љ–Њ–≥–Њ –Ј–љ–∞—З–µ–љ–Є—П –Ј–∞–і–µ—А–ґ–Ї–Є –Ј–∞–≥—А—Г–Ј–Ї–Є, –љ–Њ —Б—В–Њ–Є—В –њ—А–Є–і–µ—А–ґ–Є–≤–∞—В—М—Б—П 5 —Б–µ–Ї. –Х—Б—В—М —Б–њ–µ—Ж–Є–∞–ї—М–љ—Л–µ –Є–љ—Б—В—А—Г–Љ–µ–љ—В—Л —В–µ—Б—В–Є—А–Њ–≤–∞–љ–Є—П, –љ–∞–њ—А–Є–Љ–µ—А, GoogleSpeed вАЛвАЛInsights, Mobile Friendliness Tool –Є Fetch, –Љ–Њ–ґ–љ–Њ –њ—А–Њ–≤–µ—А–Є—В—М —В–∞–є–Љ–µ—А Max Prin.;

3) –Ю–±–љ–∞—А—Г–ґ–µ–љ–Є–µ –Њ—И–Є–±–Њ–Ї –≤ —Б—А–∞–±–∞—В—Л–≤–∞–љ–Є–Є JavaScript –Љ–Њ–ґ–µ—В –њ–Њ–≤–ї–µ—З—М –њ—А–Њ–њ—Г—Б–Ї –Њ—В–і–µ–ї—М–љ—Л—Е —Б—В—А–∞–љ–Є—Ж —А–µ—Б—Г—А—Б–∞.

–Ъ–∞–Ї –њ—А–Њ–≤–µ—А–Є—В—М, —Б–њ–Њ—Б–Њ–±–љ—Л –ї–Є —А–Њ–±–Њ—В—Л —Б–Ї–∞–љ–Є—А–Њ–≤–∞—В—М –Є —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞—В—М —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–µ?

1) –Ґ–µ—Б—В–Є—А–Њ–≤–∞–љ–Є–µ.

–Я–Њ–Є—Б–Ї–Њ–≤—Л–µ –∞–ї–≥–Њ—А–Є—В–Љ—Л –њ–Њ—Б—В–Њ—П–љ–љ–Њ —А–∞–Ј–≤–Є–≤–∞—О—В—Б—П, –њ–Њ–ї—Г—З–∞—П –љ–Њ–≤—Л–µ –Љ–µ—В–Њ–і–Є–Ї–Є –Њ—Ж–µ–љ–Ї–Є –Є —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є—П —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–≥–Њ. –Т 2015 –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ —А–Њ–±–Њ—В—Л –љ–∞—Г—З–Є–ї–Є—Б—М –∞–љ–∞–ї–Є–Ј–Є—А–Њ–≤–∞—В—М JavaScript, –њ—А–Є–Љ–µ–љ—П—П DOM. –Ю—В—Б—О–і–∞ —Б–ї–µ–і—Г–µ—В –≤—Л–≤–Њ–і, –µ—Б–ї–Є –≤—Л –Љ–Њ–ґ–µ—В–µ –њ—А–Њ—Б–Љ–Њ—В—А–µ—В—М —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–µ –≤–∞—И–Є—Е —Б—В—А–∞–љ–Є—Ж –≤ DOM, —В–Њ —Б–Ї–Њ—А–µ–µ –≤—Б–µ–≥–Њ –Є –±–Њ—В—Л —Б–њ–Њ—Б–Њ–±–љ—Л –µ–≥–Њ –њ—А–Њ–∞–љ–∞–ї–Є–Ј–Є—А–Њ–≤–∞—В—М.

–С.–У–Њ—А–∞–≤–ї–µ—З —А–µ—И–Є–ї –њ—А–Њ—В–µ—Б—В–Є—А–Њ–≤–∞—В—М –Ї–Њ–Љ–±–Є–љ–∞—Ж–Є—О —А–∞–Ј–љ—Л—Е –±–Є–±–ї–Є–Њ—В–µ–Ї –Є —Д—А–µ–є–Љ–≤–Њ—А–Ї–Њ–≤ JavaScript, —З—В–Њ–±—Л —Г–Ј–љ–∞—В—М, –Ї–∞–Ї –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ –±–Њ—В—Л —А–µ–∞–≥–Є—А—Г—О—В –љ–∞ –Є—Е –љ–∞–ї–Є—З–Є–µ (–љ–∞–њ—А–Є–Љ–µ—А, –њ—А–Њ–≤–µ–і–µ–љ–Є–µ –Є–љ–і–µ–Ї—Б–∞—Ж–Є–Є —Б—В—А–∞–љ–Є—Ж –Є –Є—Е —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–≥–Њ). –Т —А–µ–Ј—Г–ї—М—В–∞—В–µ –≤—Л—П—Б–љ–Є–ї–Њ—Б—М, —З—В–Њ–± –±–Њ–ї—М—И–Є–љ—Б—В–≤–Њ –±–Є–±–ї–Є–Њ—В–µ–Ї –Є —Д—А–µ–є–Љ–≤–Њ—А–Ї–Њ–≤ –У—Г–≥–ї —Б–њ–Њ—Б–Њ–±–µ–љ –њ—А–Њ—Б–Ї–∞–љ–Є—А–Њ–≤–∞—В—М –Є —А–∞—Б–њ–Њ–Ј–љ–∞—В—М, –Є–љ–Њ–≥–і–∞ —Б–Њ–Ј–і–∞–≤–∞—П –і–Њ—Б—В–∞—В–Њ—З–љ–Њ —Б–ї–Њ–ґ–љ—Л–µ —Б—В—А—Г–Ї—В—Г—А—Л.

–≠—В–Њ—В —В–µ—Б—В –њ–Њ–Ї–∞–Ј–∞–ї, —З—В–Њ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ JavaScript –і–Њ–њ—Г—Б—В–Є–Љ–Њ, –љ–Њ –љ—Г–ґ–љ–Њ –њ—А–Њ–≤–µ—А—П—В—М —Б–Њ–≤–Љ–µ—Б—В–Є–Љ–Њ—Б—В—М –≤—Л–±—А–∞–љ–љ—Л—Е –±–Є–±–ї–Є–Њ—В–µ–Ї –Є —Д—А–µ–є–Љ–≤–Њ—А–Ї–Њ–≤ —Б –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ–Є –±–Њ—В–∞–Љ–Є.

–≠—В–Њ –Љ–Њ–ґ–љ–Њ —Б—А–∞–≤–љ–Є—В—М —Б –≤—Л—Б–Ї–∞–Ј—Л–≤–∞–љ–Є–µ–Љ –Ф. –Ъ–Њ–ї–ї–Є–љ–∞ –њ—А–Њ –њ—Г–ї–Є –Є –њ—Г—И–Ї–Є:

«–Я—Г–ї—О –Љ–Њ–ґ–љ–Њ —Б—А–∞–≤–љ–Є—В—М —Б —Н–Љ–њ–Є—А–Є—З–µ—Б–Ї–Є–Љ —Н–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В–Њ–Љ, –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–Љ –і–ї—П –Њ–њ—А–µ–і–µ–ї–µ–љ–Є—П —А–∞–±–Њ—В–Њ—Б–њ–Њ—Б–Њ–±–љ–Њ—Б—В–Є –Њ–±—К–µ–Ї—В–∞. –Я—Г–ї—П –і–Њ–ї–ґ–љ–∞ –Њ–±–ї–∞–і–∞—В—М —В—А–µ–Љ—П –њ–∞—А–∞–Љ–µ—В—А–∞–Љ–Є: –љ–µ–і–Њ—А–Њ–≥–Њ–є —Б—В–Њ–Є–Љ–Њ—Б—В—М—О, –љ–Є–Ј–Ї–Є–Љ —Г—А–Њ–≤–љ–µ–Љ —А–Є—Б–Ї–∞ –њ—А–Є –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–Є –Є –љ–Є–Ј–Ї–Њ–є –Њ—В–і–∞—З–µ–є. –Ю–њ–Є—А–∞—П—Б—М –љ–∞ —Н–Љ–њ–Є—А–Є—З–µ—Б–Ї–Є–є —Н–Ї—Б–њ–µ—А–Є–Љ–µ–љ—В, –њ—А–Њ–Є—Б—Е–Њ–і–Є—В –Ї–Њ–љ—Ж–µ–љ—В—А–∞—Ж–Є—П —А–µ—Б—Г—А—Б–Њ–≤, —З—В–Њ–±—Л —Б—В—А–µ–ї—П—П –Є–Ј –њ—Г—И–Ї–Є, –њ–Њ–ї—Г—З–Є—В—М –Љ–∞–Ї—Б–Є–Љ–∞–ї—М–љ—Г—О –≤—Л–≥–Њ–і—Г.»

–Ь–Њ–ґ–љ–Њ –њ–Њ–ї—М–Ј–Њ–≤–∞—В—М—Б—П —Б–ї–µ–і—Г—О—Й–Є–Љ –∞–ї–≥–Њ—А–Є—В–Љ–Њ–Љ –њ—А–Њ–≤–µ—А–Ї–Є –і–Њ—Б—В—Г–њ–љ–Њ—Б—В–Є –Ї–Њ–љ—В–µ–љ—В–∞ –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е —А–Њ–±–Њ—В–Њ–≤:

1) –Я—А–Њ–≤–µ—А–Є—В—М –і–Њ—Б—В—Г–њ–љ–Њ—Б—В—М –Ї–Њ–љ—В–µ–љ—В–∞ –≤ DOM;

2) –Я—А–Њ–≤–µ—А–Є—В—М —Б—В—А—Г–Ї—В—Г—А—Г —А–µ—Б—Г—А—Б–∞ –љ–∞ –љ–∞–ї–Є—З–Є–µ –≤–љ—Г—В—А–µ–љ–љ–Є—Е —Б–≤—П–Ј–µ–є;

3) –Т—А—Г—З–љ—Г—О –њ—А–Њ–≤–µ—А–Є—В—М –љ–µ–Ї–Њ—В–Њ—А—Л–µ —Н–ї–µ–Љ–µ–љ—В—Л –≤–µ–±—Б—В—А–∞–љ–Є—Ж;

4) –Ш—Б–њ–Њ–ї—М–Ј—Г–є—В–µ –Є–љ—Б—В—А—Г–Љ–µ–љ—В—Л –і–ї—П –њ—А–Њ–≤–µ—А–Ї–Є –≤–Є–і–Є–Љ–Њ—Б—В–Є –Ї–Њ–љ—В–µ–љ—В–∞ –њ–Њ–Є—Б–Ї–Њ–≤–Њ–є —Б–Є—Б—В–µ–Љ–Њ–є;

5) –Ю—Ж–µ–љ–Є—В–µ —Б–Ї–Њ—А–Њ—Б—В—М –Ј–∞–≥—А—Г–Ј–Ї–Є –њ–Њ—Б–ї–µ —Б—А–∞–±–∞—В—Л–≤–∞–љ–Є—П —Б–Њ–±—Л—В–Є—П JavaScript –њ—А–Є –њ–Њ–Љ–Њ—Й–Є Fetch —Б Google. –≠—В–Њ —Б–њ–Њ—Б–Њ–±–љ–Њ –Њ—В–Њ–±—А–∞–Ј–Є—В—М –≤–Њ–Ј–Љ–Њ–ґ–љ—Л–µ –њ—А–Њ–±–ї–µ–Љ—Л, —Б–≤—П–Ј–∞–љ–љ—Л–µ —Б –±–ї–Њ–Ї–Є—А–Њ–≤–Ї–Њ–є –Њ—В–і–µ–ї—М–љ—Л—Е —Н–ї–µ–Љ–µ–љ—В–Њ–≤, —Н—В–Њ –Љ–Њ–ґ–љ–Њ —Г–≤–Є–і–µ—В—М –≤ —Д–∞–є–ї–µ robots.txt.

–Я—А–Є–Љ–µ—З–∞–љ–Є–µ. –Х—Б–ї–Є —Г –≤–∞—Б –љ–µ—В –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –њ—А–Њ–≤–µ—А–Є—В—М —А–µ—Б—Г—А—Б —З–µ—А–µ–Ј GSC, –Љ–Њ–ґ–љ–Њ –≤–Њ—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М—Б—П ¬ЂAny Bot Tool¬ї Technicalseo.com

–Т—Л –њ—А–Њ–≤–µ–ї–Є –њ—А–Њ–≤–µ—А–Ї—Г –Є –Њ–±–љ–∞—А—Г–ґ–Є–ї–Є, —З—В–Њ –µ—Б—В—М –љ–µ–Є—Б–њ—А–∞–≤–љ–Њ—Б—В–Є? –Ш–ї–Є –Є—Б–њ–Њ–ї—М–Ј—Г–µ–Љ—Л–µ –≤–∞–Љ–Є –Љ–µ—В–∞–і–∞–љ–љ—Л–µ –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ—Л –і–ї—П –њ–Њ–Є—Б–Ї–Њ–≤—Л—Е –±–Њ—В–Њ–≤ —Б–Њ—Ж—Б–µ—В–µ–є (–§–µ–є—Б–±—Г–Ї, —В–≤–Є—В–µ—А –Є —В.–і)? –Ф–ї—П —А–µ—И–µ–љ–Є—П —Н—В–Є—Е –Є –і—А—Г–≥–Є—Е –њ—А–Њ–±–ї–µ–Љ —Б–ї–µ–і—Г–µ—В —Б–і–µ–ї–∞—В—М HTML SNAPSHOTS.

2) HTML SNAPSHOTS.

HTML SNAPSHOTS — —Н—В–Њ –Њ—В–Њ–±—А–∞–ґ–µ–љ–Є–µ —Б—В—А–∞–љ–Є—Ж—Л, –Ї–Њ—В–Њ—А—Г—О –≤–Є–і—П—В –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ –±–Њ—В—Л (—Б—В–∞—В–Є—З–µ—Б–Ї–∞—П –≤–µ—А—Б–Є—П DOM).

–Т–њ–µ—А–≤—Л–µ –Њ–љ–Є –њ–Њ—П–≤–Є–ї–Є—Б—М –≤ 2009, –≤ 2015 –У—Г–≥–ї —А–µ—И–Є–ї –Њ—В–Ї–∞–Ј–∞—В—М—Б—П –Њ—В —Н—В–Њ–≥–Њ –Љ–µ—В–Њ–і–∞. –Ґ–µ–Љ –љ–µ –Љ–µ–љ–µ–µ –Њ–љ–Є –њ–Њ–Љ–Њ–≥–∞—О—В —А–∞–Ј–Њ–±—А–∞—В—М—Б—П —Б –≤—Л—П–≤–ї–µ–љ–љ—Л–Љ–Є —В—А—Г–і–љ–Њ—Б—В—П–Љ–Є.

–Э–∞–њ—А–Є–Љ–µ—А, –µ—Б–ї–Є –≤—Л –Њ–±–љ–∞—А—Г–ґ–Є–ї–Є, —З—В–Њ –њ–Њ–Є—Б–Ї–Њ–≤—Л–µ –±–Њ—В—Л –љ–µ —А–∞—Б–њ–Њ–Ј–љ–∞—О—В –≤–∞—И–Є —Н–ї–µ–Љ–µ–љ—В—Л JavaScript, —В–Њ –≤—Л –Љ–Њ–ґ–µ—В–µ –њ—А–µ–і–Њ—Б—В–∞–≤–Є—В—М HTML SNAPSHOT —Б—В—А–∞–љ–Є—Ж—Л, —З—В–Њ–±—Л –±–Њ—В —Б–Љ–Њ–≥ –њ—А–Њ–Є–љ–і–µ–Ї—Б–Є—А–Њ–≤–∞—В—М –Є –Њ—Ж–µ–љ–Є—В—М —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–µ.

–°—В–Њ–Є—В —Г—З–Є—В—Л–≤–∞—В—М, —З—В–Њ –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Є —Б—В—А–µ–Љ—П—В—Б—П –њ–Њ–ї—Г—З–∞—В—М —В–µ –ґ–µ –і–∞–љ–љ—Л–µ, —З—В–Њ –Є –њ–Њ—Б–µ—В–Є—В–µ–ї—М –≤–∞—И–µ–≥–Њ —А–µ—Б—Г—А—Б–∞, –њ–Њ—Н—В–Њ–Љ—Г –њ–Њ–ї—М–Ј–Њ–≤–∞—В—М—Б—П HTML SNAPSHOT —Б—В–Њ–Є—В –ї–Є—И—М –≤ —В–µ—Е —Б–ї—Г—З–∞—П—Е, –Ї–Њ–≥–і–∞ –љ–µ—В –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –Є—Б–њ—А–∞–≤–Є—В—М —В—А—Г–і–љ–Њ—Б—В–Є –Є–Ј-–Ј–∞ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є—П JavaScript.

–Я—А–Є–Љ–µ—З–∞–љ–Є–µ.

–У—Г–≥–ї –њ—А–Њ–і–Њ–ї–ґ–∞–µ—В –њ–Њ–і–і–µ—А–ґ–Є–≤–∞—В—М —А–∞–±–Њ—В—Г —Б HTML SNAPSHOT, –љ–Њ —А–µ–Ї–Њ–Љ–µ–љ–і—Г–µ—В –Є–Ј–±–µ–≥–∞—В—М –µ–≥–Њ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ, –∞—А–≥—Г–Љ–µ–љ—В–Є—А—Г—П —Н—В–Њ —В–µ–Љ, —З—В–Њ:

1) –Ю–љ–Є –Њ—А–Є–µ–љ—В–Є—А—Г—О—В—Б—П –љ–∞ –њ–Њ–ї—Г—З–µ–љ–Є–µ —Б—В—А–∞–љ–Є—Ж –≤ —В–Њ–Љ –ґ–µ –≤–Є–і–µ, —З—В–Њ –Є –њ–Њ–ї—М–Ј–Њ–≤–∞—В–µ–ї–Є —А–µ—Б—Г—А—Б–∞;

2) –Я–Њ–њ—Л—В–Ї–Є –Њ–±–Љ–∞–љ–∞ –≤ –≤–Є–і–µ –њ—А–µ–і–Њ—Б—В–∞–≤–ї–µ–љ–Є—П –Њ—В–ї–Є—З–љ–Њ–≥–Њ —Б–Њ–і–µ—А–ґ–∞–љ–Є—П —Б–љ–Є–Љ–Ї–∞ –Њ—В –Њ—А–Є–≥–Є–љ–∞–ї—М–љ–Њ–є —Б—В—А–∞–љ–Є—Ж—Л. –Я—А–Є —Н—В–Њ–Љ —Б–Њ–і–µ—А–ґ–∞–љ–Є–µ —Б–љ–Є–Љ–Ї–∞ –Є –Њ—А–Є–≥–Є–љ–∞–ї–∞ –љ–µ –і–Њ–ї–ґ–љ—Л –Њ—В–ї–Є—З–∞—В—М—Б—П. –Я—А–Є –Њ–±–љ–∞—А—Г–ґ–µ–љ–Є–Є –њ–Њ–њ—Л—В–Њ–Ї –Њ–±–Љ–∞–љ–∞ –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ –љ–∞–ї–Њ–ґ–µ–љ–Є–µ —И—В—А–∞—Д–∞.

–Э–µ—Б–Љ–Њ—В—А—П –љ–∞ —Н—В–Є –љ–µ–і–Њ—Б—В–∞—В–Ї–Є, –µ—Б—В—М —А—П–і –њ—А–µ–Є–Љ—Г—Й–µ—Б—В–≤:

1) –Я–Њ–Є—Б–Ї–Њ–≤—Л–є –±–Њ—В –У—Г–≥–ї –њ–Њ–ї—Г—З–∞–µ—В –њ—А–µ–і—Б—В–∞–≤–ї–µ–љ–Є–µ –Њ –Ї–Њ–љ—В–µ–љ—В–µ —Б—В—А–∞–љ–Є—Ж—Л, –і–∞–ґ–µ –µ—Б–ї–Є –љ–µ —Б–њ–Њ—Б–Њ–±–µ–љ —А–∞—Б–њ–Њ–Ј–љ–∞—В—М –љ–µ–Ї–Њ—В–Њ—А—Л–µ —Н–ї–µ–Љ–µ–љ—В—Л JavaScript;

2) –Я–Њ–Є—Б–Ї–Њ–≤—Л–µ –±–Њ—В—Л –і—А—Г–≥–Є—Е —Б–Є—Б—В–µ–Љ —Б–њ–Њ—Б–Њ–±–љ—Л —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞—В—М —Б–Њ–і–µ—А–ґ–Є–Љ–Њ–µ —Б—В—А–∞–љ–Є—Ж, –≤–µ–і—М –і–∞–ї–µ–Ї–Њ –љ–µ –≤—Б–µ —Б—Г—Й–µ—Б—В–≤—Г—О—Й–Є–µ –њ–Њ–Є—Б–Ї–Њ–≤–Є–Ї–Є —А–∞–±–Њ—В–∞—О—В —Б JavaScript.

–Ы–Њ–Ї–∞–ї–Є–Ј–∞—Ж–Є—П —Б–∞–є—В–∞

–Ъ–Њ–≥–і–∞ –±—А–∞—Г–Ј–µ—А –њ–Њ–ї—Г—З–∞–µ—В —Б—В—А–∞–љ–Є—Ж—Г –Њ—В —Б–µ—А–≤–µ—А–∞, –Њ–љ —Б–Њ–Ј–і–∞–µ—В DOM –Њ–±—А–∞–Ј, –њ—А–Є —Н—В–Њ–Љ –±–Њ–ї—М—И–∞—П —З–∞—Б—В—М —Н–ї–µ–Љ–µ–љ—В–Њ–≤ –њ–Њ–і–≥—А—Г–ґ–∞–µ—В—Б—П –≤ –Ј–∞–≤–Є—Б–Є–Љ–Њ—Б—В–Є –Њ—В –Љ–µ—Б—В–∞ —А–∞—Б–њ–Њ–ї–Њ–ґ–µ–љ–Є—П –љ–∞ –≤–µ–±—Б—В—А–∞–љ–Є—Ж–µ. –Х—Б–ї–Є –≤—Л —А–∞–Ј–Љ–µ—Б—В–Є—В–µ –Ї—А—Г–њ–љ—Л–є –Њ–±—К–µ–Ї—В –≤ –љ–∞—З–∞–ї–µ, —В–Њ –Њ–љ –±—Г–і–µ—В –Ј–∞–≥—А—Г–ґ–∞—В—М—Б—П –њ–µ—А–≤—Л–Љ.

–У—Г–≥–ї –љ–∞—Ж–µ–ї–Є–≤–∞–µ—В –љ–∞ –Ј–∞–≥—А—Г–Ј–Ї—Г –і–∞–љ–љ—Л—Е —В–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, —З—В–Њ–±—Л –њ–µ—А–≤—Л–Љ–Є –Њ—В–Њ–±—А–∞–ґ–∞–ї–Є—Б—М —Б–∞–Љ—Л–µ –≤–∞–ґ–љ—Л–µ –Є –њ–Њ–ї–µ–Ј–љ—Л–µ –і–ї—П –њ–Њ—Б–µ—В–Є—В–µ–ї–µ–є.

–Я—Г—В—М —А–µ–љ–і–µ—А–Є–љ–≥–∞ — –Њ–њ—В–Є–Љ–Є–Ј–∞—Ж–Є—П –Ј–∞–≥—А—Г–Ј–Ї–Є –њ–Њ –≤–∞–ґ–љ–Њ—Б—В–Є. –Я—А–Є —Н—В–Њ–Љ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ–Є–µ JavaScript, –±–µ–Ј –Ї–Њ—В–Њ—А–Њ–≥–Њ –Љ–Њ–ґ–љ–Њ –Њ–±–Њ–є—В–Є—Б—М, –Љ–Њ–ґ–µ—В –Ј–∞–Љ–µ–і–ї–Є—В—М —Б–Ї–Њ—А–Њ—Б—В—М –Ј–∞–≥—А—Г–Ј–Ї–Є —Б—В—А–∞–љ–Є—Ж—Л, –±–ї–Њ–Ї–Є—А—Г—П –њ–Њ—В–µ–љ—Ж–Є–∞–ї (–≤–Њ—Б–њ—А–Є–љ–Є–Љ–∞–µ–Љ–∞—П –ї–∞—В–µ–љ—В–љ–Њ—Б—В—М).

–°–њ–Њ—Б–Њ–±—Л —А–µ—И–µ–љ–Є—П Render-blocking JavaScript.

–Х—Б—В—М –Љ–љ–Њ–ґ–µ—Б—В–≤–Њ –Є–љ—Б—В—А—Г–Љ–µ–љ—В–Њ–≤, –њ–Њ–Ј–≤–Њ–ї—П—О—Й–Є—Е –њ—А–Њ–≤–µ—А–Є—В—М —Б–Ї–Њ—А–Њ—Б—В—М –Ј–∞–≥—А—Г–Ј–Ї–Є –≤–µ–±—Б—В—А–∞–љ–Є—Ж—Л, –љ–∞–њ—А–Є–Љ–µ—А, Speed SpeedWare, WebPageTest.org, CatchPoint, —Б–њ–Њ—Б–Њ–±–љ—Л—Е –Њ—Ж–µ–љ–Є—В—М –≤–ї–Є—П–љ–Є–µ —Н–ї–µ–Љ–µ–љ—В–Њ–≤ JavaScript –љ–∞ —Б–Ї–Њ—А–Њ—Б—В—М. –Я—А–Є –≤—Л—П–≤–ї–µ–љ–Є–Є –њ—А–Њ–±–ї–µ–Љ –Љ–Њ–ґ–љ–Њ:

1) Inline — –і–Њ–±–∞–≤–Є—В—М JavaScript –≤ HTML-–і–Њ–Ї—Г–Љ–µ–љ—В;

2) Async — –∞—Б–Є–љ—Е—А–Њ–љ–Є–Ј–Є—А–Њ–≤–∞—В—М JavaScript, –і–Њ–±–∞–≤–Є–≤ –∞—В—А–Є–±—Г—В async –Ї HTML-—В–µ–≥—Г;

3) –Ю—В–ї–Њ–ґ–Є—В—М — —А–∞—Б–њ–Њ–ї–Њ–ґ–Є—В—М —Н–ї–µ–Љ–µ–љ—В JavaScript –≤ –љ–Є–ґ–љ–µ–є —З–∞—Б—В–Є —Б—В—А–∞–љ–Є—Ж—Л.

–°—В–Њ–Є—В –Њ—В–Љ–µ—В–Є—В—М, —З—В–Њ –≤—Л–Ј—Л–≤–∞–µ–Љ—Л–µ —Б—Ж–µ–љ–∞—А–Є–Є —Б–ї–µ–і—Г–µ—В —А–∞—Б—Б—В–∞–≤–Є—В—М –њ–Њ –њ—А–Є–Њ—А–Є—В–µ—В–љ–Њ—Б—В–Є. –Т—Л –љ–µ –і–Њ–ї–ґ–љ—Л –Љ–µ–љ—П—В—М –Њ—З–µ—А–µ–і–љ–Њ—Б—В—М –Є—Б–њ–Њ–ї–љ–µ–љ–Є—П —Б—Ж–µ–љ–∞—А–Є–µ–≤, –Є–ї–Є –Ј–∞–њ—Г—Б–Ї–∞—В—М —Б—Ж–µ–љ–∞—А–Є–є –і–Њ –Ј–∞–≤–µ—А—И–µ–љ–Є—П –њ—А–µ–і—Л–і—Г—Й–µ–≥–Њ –і–µ–є—Б—В–≤–Є—П (–љ–∞–њ—А–Є–Љ–µ—А, –і–Њ –Њ—В–Ї—А—Л—В–Є—П –і—А—Г–≥–Њ–≥–Њ —Д–∞–є–ї–∞, –љ–∞ –Ї–Њ—В–Њ—А—Л–є –µ—Б—В—М —Б—Б—Л–ї–Ї–∞ –≤ —Б—Ж–µ–љ–∞—А–Є–Є). –†–∞–±–Њ—В–∞—В—М –љ–∞–і —Н—В–Є–Љ –і–Њ–ї–ґ–µ–љ –≥—А–∞–Љ–Њ—В–љ—Л–є —Б–њ–µ—Ж–Є–∞–ї–Є—Б—В.

–Я–Њ–і—А–Њ–±–љ–µ–µ:¬†–Ф–Њ–Ї—Г–Љ–µ–љ—В–∞—Ж–Є—П –њ–Њ —Б–Ї–Њ—А–Њ—Б—В–Є —А–∞–Ј—А–∞–±–Њ—В–Ї–Є Google Developer

–Ш—В–Њ–≥–Є.

–Я–Њ–Є—Б–Ї–Њ–≤—Л–µ —Б–Є—Б—В–µ–Љ—Л —Б—В–∞—А–∞—О—В—Б—П —Б–Њ–Ј–і–∞—В—М –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ—Б—В–Є –і–ї—П —Б–Ї–∞–љ–∞, –∞–љ–∞–ї–Є–Ј–∞ –Є —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є—П JavaScript, –љ–Њ –≤—Б–µ –µ—Й–µ –µ—Б—В—М –њ—А–Њ–±–ї–µ–Љ—Л —Б —Н—В–Є–Љ. –Ю–±—П–Ј–∞—В–µ–ї—М–љ–Њ –њ—А–Њ–≤–µ—А—М—В–µ, —З—В–Њ —Б–Њ–і–µ—А–ґ–∞–љ–Є–µ –≤–∞—И–Є—Е —Б—В—А–∞–љ–Є—Ж –њ—А–Њ–≤–µ—А—П–µ—В—Б—П –њ–Њ–Є—Б–Ї–Њ–≤—Л–Љ–Є –±–Њ—В–∞–Љ–Є. –Я—А–Є –≤—Л—П–≤–ї–µ–љ–Є–Є –њ—А–Њ–±–ї–µ–Љ –Є—Й–Є—В–µ —Б–њ–Њ—Б–Њ–±—Л –Є—Е –њ—А–µ–Њ–і–Њ–ї–µ–љ–Є—П.